All About Big Data

PENGANTAR KOMPUTASI MODERN

ALL ABOUT BIG DATA

DISUSUN OLEH:

MELTHA ALHIDAYA PUTRA (56414585)

MUHAMMAD WILDAN AVIANTO (57414583)

KELAS : 4IA10

DOSEN : RHEZA ANDIKA

PROGRAM STUDI TEKNIK INFORMATIKA

UNIVERSITAS GUNADARMA

2018

KATA PENGANTAR

KATA PENGANTAR

Puji

syukur penulis panjatkan kepada Allah SWT karena dengan anugerah inspirasi yang

diberikan Allah SWT sungguh menjadi sumber pengetahuan bagi penulis dalam

menyelesaikan penulisan makalah yang berjudul “BIG DATA”. Makalah ini disusun

sebagai tugas kelompok mata kuliah Pengantar Komputasi Modern.

Semoga makalah ini dapat memberi manfaat dan sumber informasi bagi penulis dan pembaca.

Semoga makalah ini dapat memberi manfaat dan sumber informasi bagi penulis dan pembaca.

Depok, 25 Maret 2018

Penyusun

BAB I

Pendahuluan

1.1. Latar Belakang

Perkembangan arus informasi dewasa ini sudah

sangat jauh melampui di banding abad ke-19. Perkembangan informasi ini secara

langsung mempengaruhi kehidupan baik itu manusia maupun organisasi. Salah satu

hal yang berubah adalah cara menggunakan data. Perkembangan teknologi informasi

telah membuat tiap individu memiliki data yang lengkap dan dapat ter-update secara real time baik melalui

laptop, smart phone dan lainnya. Penggunaan tiap individu ini secara bersama

sama akan menciptakan arus informasi yang sangat besar tiap harinya. Kemudahaan

dalam mengakses informasi dengan melalui internet akan meciptakan dunia tanpa

batas atau boderless sehingga para

individu tidak lagi terkendala waktu dan jarak terhadap informasi yang mereka

ingin peroleh. Dengan terjadinya perkembangan teknologi, data menjadi hal yang

penting dalam menjalankan berbagai hal. Beberapa diantaranya adalah mengetahui

tren pasar, mengetahui keinginan konsumen, meningkatakn pengetahuan pemerintah

terhadap kepuasan layanan publi dan banyak hal lainnya yang bisa dimanfaatkan

melalui arus informasi yang begitu cepat ini.

Hasil dari perputaran informasi yang begitu

cepat ini mencitpakn data yang harus dapat diolah dengan lebih terkomputerisasi

sehingga dalam penggunaannya oleh pihak terkait dapat menjadi informasi yang

beguna. Dengan perkembangan inlah big data muncul dan mulai berkembang.

Penggunaaannya pun semakin meluas, hingga mencakup social media, tren pasar,

pemerintah dan sector lainnya.

2.3 Karakteristik Big Data

1.1 Rumusan Masalah

Berdasarkan latar belakang tersebut maka ruusan masalah

pada makalah ini adalah:

1. Bagaimana sejarah daripada Big Data?

2. Bagaimana pemahaman mengenai Big Data?

3. Bagaimana karakteristik Big Data?

4. Bagaimana kemampuan untuk memproses Big Data?

5. Bagaimana tantangan dalam pengelolaan Big Data?

6. Bagaimana masalah yang ada mengenai Big Data?

7. Bagaiamana mengaplikasikan Big Data?

8. Bagaimana pemanfaatan Big Data secara nyata?

1.1 Tujuan Penulisan Makalah

1.

Mengetahu sejarah Big Data

2.

Memahami tentang Big Data

3.

Memahami karekteristik daripada Big Data

4.

Mengetahui kemampuan utnuk memproses Big Data

5.

Memahami tantangan dalam pengelolaan Big Data

6.

Memahami masalah terkait Big Data

7.

Mengetahui penggunaan Big Data

8. Memahami pemanfaatan Big Data

BAB II

ISI

2.1 Sejarah Big

Data

Sebelum mempelajari suatu hal tentu diperlukan untuk memahami asal

muasal atau sejarah dari hal yang ingin dipelajari tersebut, ada pun tentang

topic kali ini penulis akan memperkenalkan sejarah big data. Berikut urutannya;

1944

Fremont Rider, Pustakawan universitas Wesleyan. Dia memperkirakan bahwa

Perpustakana yang ada di

amerika serikat ukurannya meningkat dua kali lipat setiap 16 tahun

1961

Derek Price. Dia mendiagramkan pertumbuhan pengetahuan ilmiah dengan cara

melihat jumlah pertumbuhan jurnal ilmiah dan makalah

dalam Komunikasi dari ACM, yang

menyatakan bahwa "ledakan informasi” tercatat dalam beberapa tahun

terakhir membuatnya penting bahwa persyaratan penyimpanan untuk semua informasi

harus dijaga agar tetap minimum.

Banyak informasi. Pengurus

tampaknya mengukur seorang pria seimbang dengan jumlah bit kapasitas penyimpanan berkas itu akan

mengisi."

1975

Departemen Pos dan Telekomunikasi di Jepang mulai melakukan Arus

Informasi Sensus, pelacakan

volume informasi yang beredar di Jepang (ide pertama kali diusulkan dalam makalah 1969)

1980

I.A. Tjomsland memberikan ceramah berjudul "Where do we go from

here?"

Di IEEE Keempat Symposium on

Mass Storage Systems, dia mengatakan "Mereka yang terkait dengan perangkat

penyimpanan lama menyadari bahwa Hukum parkinson Pertama dapat diparafrasekan untuk

menggambarkan Industry kami 'Data mengembang untuk mengisi ruang yang

tersedia'.

1981

Kantor Pusat statistic hungaria memulai proyek penelitian untuk menjelaskan

informasi indsutri negara, termasuk mengukur Volume

informasi dalam bit.

1983

Ithiel de Sola Pool menerbitkan "Pelacakan Arus Informasi" di

Science.

Melihat tren pertumbuhan di 17

Media komunikasi utama 1960-1977, ia menyimpulkan bahwa "kata-kata yang

tersedia untuk Amerika (di atas usia 10) melalui media ini tumbuh pada

tingkat 8,9 persen per tahun, kata-kata benar benar hadir untuk dari

media tersebut tumbuh hanya 2,9 persen per tahun, Pada periode

pengamatan, sebagian besar pertumbuhan arus informasi adalah karena

pertumbuhan penyiaran, Tapi menjelang akhir periode [1977] situasi berubah:

media point-to-point yang tumbuh lebih cepat dari penyiaran.".

Pada tahun 2005 Roger Mougalas dari O’Reilly Media

menciptakan istilah Big Data untuk pertama kalinya, hanya setahun setelah

mereka membuat istilah Web 2.0. Itu mengacu pada serangkaian data besar yang

hampir tidak mungkin untuk mengelola dan memproses dengan menggunakan tools

business intelligence tradisional.

2005 merupakan tahun ketika Hadoop dibuat oleh Yahoo!

dibangun di atas MapReduce milik Google. Hal tersebut merupakan tujuan untuk

melakukan index terhadap seluruh data World

Wide Web dan saat ini Hadoop

sebagaiopen-source digunakan

oleh banyak organisasi untuk menyimpan data dalam jumlah besar.

Seiring

banyak jejaring sosial yang mulai bermunculan, Web 2.0 mulai semakin populer

dan lebih banyak data dihasilkan setiap harinya. BanyakStartup mulai menggunakan data yang sangat

besar dan juga bidang pemerintahan mulai bekerja menggunakan proyek Big Data. Pada tahun 2009

pemerintah India memutuskan untuk mengambil iris

scan, sidik jari, dan juga foto dari 1.2 juta penduduk. Semua data

tersebut disimpan dalamdatabase biometrik

terbesar di dunia.

Pada tahun 2010 Eric Schmidt berbicara pada konfrensi Techonomy di Lake Tahoe, California dan dia

menyatakan bahwa “terdapat 5 exabytes informasi yang dibuat oleh seluruh

dunia diantara awal peradaban dan tahun 2003. Sekarang jumlah yang sama

tersebut dibuat setiap dua hari.”

Pada

tahun 2011 McKinsey pada seminar Big

Data: The next frontier

for innovation,competition, and productivity, mengatakan bahwa pada tahun 2018

Amerika Serikat sendiri akan menghadapi kekurangan 140.000-190.000 data scientist dan juga 1.5 juta data managers.

Dalam beberapa tahun terakhir, jumlah Startups Big Data terus berkembang dalam jumlah besar,

semua mencoba untuk menghadapi Big

Data dan membantu

organisasi-organisasi untuk memahami Big

Data dan semakin

banyak perusahaan yang secara perlahan mengadopsi dan bergerak ke arahBig

Data. Walaupun Big Data telah ada sejak lama, faktanya Big Data ada ketika internet ada pada tahun

1993. Revolusi Big Data ada dihadapan kita dan masih banyak

perubahan yang akan terjadi pada tahun-tahun mendatang. (Disadur dari tulisan

Mark Van Rijmenam, CEO Datafloq).

2.2 Pembahasan Mengenai Big Data

Akhir-akhir ini, istilah 'big data' menjadi topik yang dominan dan

sangat sering dibahas dalam industri IT. Banyak pihak yang mungkin heran kenapa

topik ini baru menjadi pusat perhatian padahal ledakan informasi telah terjadi

secara berkelangsungan sejak dimulainya era informasi. Perkembangan volume dan

jenis data yang terus meningkat secara berlipat-lipat dalam dunia maya Internet

semenjak kelahirannya adalah fakta yang tak dapat dipungkiri. Mulai data yang

hanya berupa teks, gambar atau foto, lalu data berupa video hingga data yang

berasal system pengindraan. Lalu kenapa baru sekarang orang ramai-ramai

membahas istilah big data? Apa sebenarnya 'big data' itu?

Hingga saat ini, definisi resmi dari istilah big data belum ada.

Namun demikian, latar belakang dari munculnya istilah ini adalah fakta yang

menunjukkan bahwa pertumbuhan data yang terus berlipat ganda dari waktu ke

waktu telah melampaui batas kemampuan media penyimpanan maupun sistem database

yang ada saat ini.

Big Data adalah teknologi baru pengelolaan informasi.

Saat ini kita mengenal relational data store dan warehouse yang digunakan

banyak perusahaan untuk mendapatkan informasi, melakukan analisis, dan prediksi

dari data-data yang mereka miliki. Lalu apakah BIG DATA akan menggantikan

teknologi data relasional?

Dalam pembahasan mengenai topic big data saat ini

kelompok kami kurang setuju dengan pengertian yang di utarakan oleh beberapa

ahli, karena dari apa yang di pelajari yang termasuk ke dalam “BIG DATA” adalah

semua data yang tidak dapat diolah atau dianalisis menggunakan proses dan tools

yang umum digunakan saat ini. Disadari atau tidak saat ini individu maupun

organisasi apapun memiliki akses yang luas sekali terhadap informasi dengan

adanya internet tapi hanya sedikit dari mereka yang mampu mendapatkan value

dari informasi tersebut karena kebanyakan informasi itu tersedia dalam bentuk

“mentah”, tidak terstruktur atau semi-terstruktur. Oleh karena keterbatasan

pemahaman akan informasi itulah yang pada akhirnya menyebabkan mereka tidak

tahu apakah informasi yang ada itu berharga untuk mereka atau tidak. Dapat di

analogikan ke dalam perkembangan internet saat ini seperti bumi kita yang

tercinta, maka BIG DATA adalah batu bara di jaman batu, mudah ditemukan tetapi

sedikit yang tahu kegunaannya.

1. Volume

Seberapa besar data yang bisa anda olah saat ini? Apakah dengan

jumlah data yang anda miliki anda sudah lebih baik dibanding kompetitor? Data

yang ada saat ini berukuran sangat besar. Di tahun 2000 saja tercatat 800,000

petabyte data tersimpan di seluruh dunia dan angka ini diperkirakan akan

mencapai 35 zettabyte di tahun 2020 atau bahkan lebih. Bayangkan jika anda

membutuhkan analisis terhadap 1 persen saja dari seluruh data untuk mendapatkan

keuntungan dibandingkan kompetitor anda, apakah teknologi yang anda miliki

sekarang mampu melakukannya?

2.

Variety

Selain data relasional, data apa saja yang umum dianalisis? Dengan

meledaknya jumlah sensor, dan perangkat pintar , dan juga teknologi social

networking yang menghasilkan data-data yang akan sulit jika harus disimpan di

dalam relasional database. Kita tidak akan pernah tahu jika kita tidak

menyimpan semua data yang tidak terstruktur ini seperti halaman web, web log,

search index, forum social media, email, dokumen, data sensor, dll. Data-data

seperti inilah yang mungkin akan memberikan keuntungan jika kita mampu

mengolahnya.

3.

Velocity

Seberapa cepat kita dapat memproses data yang ada? Mungkin hal itu

yang pertama ada dalam benak anda ketika anda membaca ini. Namun sebenarnya

velocity di sini kita lihat dari persepsi seberapa cepat kita mampu mendapatkan

hasil analisis terhadap aliran data yang terus mengalir di saat yang hampir

bersamaan dengan datangnya data tersebut. Bayangkan jika kita memiliki sistem

yang mampu mendeteksi buronan yang tertangkap kamera cctv, ataumendeteksi dini

titik kritis seorang bayi dari suhu tubuh, tekanan darah, denyut jantung,

kecepatan bernafas bayi tersebut, melakukan sensor terhadap kata kasar atau

kata yang tidak seharusnya diucapkan yang diucapkan pada siaran langsung di tv

atau pada percakapan telepon customer service sebuah perusahaan.

Big Data adalah kesempatan bukan pengganti teknologi pengelolaan

data yang ada saat ini. Sekarang bayangkan kemampuan untuk menganalisis BIG

DATA digabungkan dengan teknologi basis data relasional dan warehousing yang

ada saat ini untuk mendapatkan keuntungan.

2.4 Kesadaran Akan Pentingnya

Kemampuan Untuk Memproses Big Data

Dari segi teknologi,

dipublikasikannya GoogleBigtable pada 2006 telah menjadi moment

muncul dan meluasnya kesadaran akan pentingnya kemampuan untuk memproses ‘big

data’. Berbagai layanan yang disediakan Google, yang melibatkan pengolahan data

dalam skala besar termasuk search engine-nya, dapat beroperasi

secara optimal berkat adanya Bigtable yang merupakan sistem database berskala

besar dan cepat. Semenjak itu, teknik akses dan penyimpanan data KVS (Key-Value

Store) dan teknik komputasi paralel yang disebut MapReduce mulai

menyedot banyak perhatian.

Lalu, terinspirasi oleh konsep dalam GoogleFile System dan

MapReduce yang menjadi pondasi Google Bigtable, seorang karyawan Yahoo! bernama

Doug Cutting kemudian mengembangkan software untuk komputasi paralel

terdistribusi (distributed paralel computing) yang ditulis dengan menggunakan

Java dan diberi nama Hadoop.

Saat ini Hadoop telah menjadi project open source-nya Apache Software.

Salah satu pengguna Hadoop adalah Facebook, SNS (Social Network Service)

terbesar dunia dengan jumlah pengguna yang mencapai 800 juta lebih. Facebook

menggunakan Hadoop dalam memproses big data seperti halnya content sharing, analisa

access log, layanan message / pesan dan layanan lainnya yang melibatkan

pemrosesan big data.

Jadi, yang dimaksud dengan ‘big data’ bukanlah semata-mata hanya

soal ukuran, bukan hanya tentang data yang berukuran raksasa. Big data adalah

data berukuran raksasa yang volumenya terus bertambah, terdiri dari berbagai

jenis atau varietas data, terbentuk secara terus menerus dengan kecepatan

tertentu dan harus diproses dengan kecepatan tertentu pula. Momen awal

ketenaran istilah ‘big data’ adalah kesuksesan Google dalam memberdayakan ‘big

data’ dengan menggunakan teknologi canggihnya yang disebut Bigtable beserta

teknologi-teknologi pendukungnya.

2.5 Tantangan Big Data

Berbagai masalah dihadapi baik oleh

sector pemerintah, bisnis maupun lainnya. Sebagai contoh adalah pada sector

pemerintah yaitu pelayanan public jalan raya. Pemerintah bergelut untuk dapat

memeceahkan masalah kemacetan khususnya yang meningkat di pagi dan sore hari.

Kemampuan analisis big data diyakini mampu membantu untuk memecahkan masalah

tersebut. Namun untuk memecahkan masalah tersebut harus dapat menemukan Big

Value dari setiap informasi yang diperoleh.

Tantangan

pertama, kualitas data yang terkait dengan integritas dan ketidakteraturan

data. Data dapat bersumber dari internal maupun eksternal organisasi, sehingga

integritasnya tidak selalu terjamin, dalam pengertian kebenaran dan akurasinya

dapat dipertanggungjawabkan. Begitu pula, tidak semua data terstruktur dan,

karena itu, menjadi tidak mudah untuk memahaminya. Di seluruh dunia, volume

data tidak terstruktur diperkirakan mencapai 80% dari volume total. Cuitan

lewat Twitter merupakan contoh data yang tidak terstruktur.

Kedua,

fragmentasi data. Dalam kebanyakan organisasi, data terfragmentasi. Setiap

departemen atau bagian dan unit bisnis menyimpan data sendiri. Tidak ada

departemen yang khusus menangani manajemen keseluruhan data dan menjamin

kebenaran, konsistensi, maupun kebaruannya. Data yang terfragmentasi ini

berpotensi menghalangi Anda dalam memahami kerumitan persoalan. Anda mungkin

menyangka persoalannya mudah ditangani ketika melihat data yang tersedia di

bagian tertentu, tapi Anda mungkin terkeju ketika melihat kaitannya dengan

bagian-bagian lain dalam perusahaan.

Hasil

riset yang dilakukan oleh Economist Intelligence Unit pada 2012 menunjukkan

bahwa fragmentasi data merupakan tantangan terbesar (57%) yang dihadapi

organisasi: terlalu banyak silo sehingga data tidak ditampung secara terpusat.

Ketiga,

infrastruktur. Big data terlampau kompleks untuk dihimpun,

disimpan, dan dipahami. Pengelolaan big data membutuhkan

infrastruktur, tempat penyimpanan, bandwidth yang lebar,

peranti komputer, dan sebagainya dengan beban kerja yang sangat bervariasi.

Jumlah infrastruktur yang Anda perlukan juga bervariasi, terkadang banyak, di

waktu lain sedikit, tergantung kebutuhan. Sementara itu, membangun

infrastruktur sendiri membutuhkan biaya tinggi.

Keempat,

tantangan platform dan aplikasi. Karena big data analytics tengah

menjadi trend, tak mengherankan apabila banyak perusahaan teknologi

informasi yang terjun mengembangkan peranti yang dibutuhkan, baik berupa platform maupun

aplikasi untuk analisis. Sejumlah ahli mengingatkan bahwa sebagian peranti yang

tersedia belum sangat matang, bahkan relatif baru. Karena itu, menurut mereka,

diperlukan kejelian dalam memilihplatform dan aplikasi yang paling

sesuai dengan kebutuhan Anda, termasuk mempertimbangkan besar anggaran yang

Anda alokasikan untuk big data analytics.

Kelima,

bila Anda ingin mengembangkan kemampuan analisis, tantangan brainware tak kalah

besar. Anda perlu orang-orang yang terampil dalam menganalisis big data.

Anda memerlukan bukan hanya analis bisnis dan orang yang mampu mengoperasikan

infrastruktur dan aplikasi, tapi Anda juga membutuhkan data scientist untuk

memahami hasilbig data analytics. Anda memerlukan orang-orang yang

menguasai algoritma statistik danvisualization tools. Mereka ada, tapi

jumlahnya masih sedikit. Kekurangan orang-orang terampil dalam analisis data

bisa menjadi tantangan serius.

Keenam,

tantangan ini terkait dengan budaya organisasi. Apakah organisasi Anda relatif

adaptif terhadap perubahan dan inovatif untuk mencoba hal-hal baru? Tantangan

yang dihadapi, dalam konteks ini, ialah bahwa manajemen senior kerap tidak

memandang big data sebagai aset strategis yang sangat berharga

bagi organisasi. Maknanya, apabila Anda menganggapnya sebagai aset strategis,

maka ketika Anda terjun ke dalam proyek big data, Anda harus siap berkesperimen,

belajar, dan berkembang. Proyek big data bukanlah sesuatu yang

sekali jadi dan memerlukan proses pembelajaran.

Itulah

enam tantangan terpenting big data analytics. Namun percayalah

bahwa setiap tantangan niscaya mendorong Anda untuk menemukan jalan keluarnya.

Jalan keluar inilah yang ditawarkan oleh banyak perusahaan yang menyediakan

jasa big data

2.6 Permasalah mengenai Big

Data

2.6.1 Bukan Hanya Masalah Ukuran, Tapi Lebih pada Ragam

Kini jelas bahwa Big

Data bukan hanya

masalah ukuran yang besar, terlebih yang menjadi ciri khasnya adalah jenis

datanya yang sangat beragam dan laju pertumbuhan maupun frekwensi perubahannya

yang tinggi. Dalam hal ragam data, Big

Data tidak hanya

terdiri dari data berstruktur seperti halnya data angka-angka maupun deretan

huruf-huruf yang berasal dari sistem database mendasar seperti halnya sistem

database keuangan, tetapi juga terdiri atas data multimedia seperti data teks,

data suara dan video yang dikenal dengan istilah data tak berstruktur. Terlebih

lagi, Big Data juga mencakup data setengah

berstruktur seperti halnya data e-mail maupun XML. Dalam hal kecepatan

pertumbuhan maupun frekwensi perubahannya, Big

Data mencakup

data-data yang berasal dari berbagai jenis sensor, mesin-mesin, maupun data log

komunikasi yang terus menerus mengalir. Bahkan, juga mencakup data-data yang

tak hanya data yang berada di internal perusahaan, tetapi juga data-data di

luar perusahaan seperti data-data di Internet. Begitu beragamnya jenis data yang

dicakup dalam Big Data inilah yang kiranya dapat

dijadikan patokan untuk membedakan Big

Data dengan sistem

manajemen data pada umumnya.

2.6.2 Fokus pada Trend per-Individu, Kecepatan

Lebih Utama daripada Ketepatan

Hingga saat ini, pendayagunaan Big Data didominasi oleh perusahaan-perusahaan

jasa berbasis Internet seperti halnya Google dan Facebook. Data yang mereka

berdayakan pun bukanlah data-data internal perusahaan seperti halnya data-data

penjualan maupun data pelanggan, lebih menitik beratkan pada pengolahan

data-data teks dan gambar yang berada di Internet. Bila kita melihat gaya

pemberdayaan data yang dilakukan oleh perusahaan-perusahaan pada umumnya, yang

dicari adalah trend yang didapat dari pengolahan

data secara keseluruhan. Misalnya, dari data konsumen akan didapat informasi

tentang trendkonsumen

dengan memproses data konsumen secara keseluruhan, bukan memproses data

per-konsumen untuk mendapatkan trend per-konsumen. Dilain pihak,

perusahaan-perusahaan jasa berbasis Internet yang memanfaatkan Big Data justru memfokuskan pemberdayaan

data untuk mendapatkan informasi trendper-konsumen

dengan memanfaatkan atribut-atribut yang melekat pada pribadi tiap konsumen.

Sebut saja toko online Amazon yang memanfaatkan informasi maupun atribut yang

melekat pada diri per-konsumen, untuk memberikan rekomendasi yang sesuai kepada

tiap konsumen. Satu lagi, pemberdayaan data alaBig Data ini dapat dikatakan lebih

berfokus pada kecepatan ketimbang ketepatan.

2.7 Aplikasi Big Data

Bigdata adalah konsep, implementasi dari suatu konsep

tentunya bisa beragam. Mungkin Hadoop adalah implementasi core bigdata yang

paling populer saat ini, namun bukan berarti Hadoop adalah satu-satunya. Vendor

seperti Microsoft dan LexisNexis misalnya, masing-masing memiliki project dalam

ranah Bigdata:Dryad dan HPCC, walaupun pada akhirnya project Dryad

diskontinyu danMicrosoft fokus pada Hadoop.

Hadoop merupakan project opensource dibawah

Apache. Silahkan baca buku “Hadoop — The Definitive Guide” untuk mengetahui

lebih detail sejarah Hadoop. Hadoop merupakan implementasi opensource project

yang dapat memecahkan 3 karakteristik masalah pada Bigdata: Volume, Velocity,

dan Variety.

Seperti layaknya kernel pada sistem operasi maka Hadoop

yang terdiri dari 2 komponen utama: HDFS (Hadoop Distributed Filesystem) dan

MapReduce, membutuhkan suatu ekosistem untuk dapat memanfaatkan implementasi

Hadoop secara maksimal. Gamblangnya, ekosistem tersebut berfungsi sebagai

add-on tambahan bagi Hadoop, misalnya: Hive.

Hive memungkinkan seseorang meng-ekstrak data dari Hadoop menggunakan syntax

seperti SQL. Hive akan meng-compile SQL language tersebut kedalam MapReduce

untuk mengakses data didalam Hadoop. Dengan adanya Hive, maka seorang database

experts tidak perlu belajar Java dan membuat aplikasi MapReduce untuk dapat

mengakses serta memproses data dari Hadoop. Contoh lain project dalam ekosistem

Hadoop diantaranya Pig, HBase, Mahout, dsb.

Kebutuhan Bigdata yang semakin besar membuka peluang baru bagi

masyarakat IT untuk memasuki pasar tersebut, mulai dari membuat implementasi

core Bigdata alternatif seperti yang dilakukan oleh LexisNexis, membuat

distribusi Hadoop-stack seperti yang dilakukan oleh Cloudera, MapR, ataupunhortonworks, hingga aplikasi yang bermain dalam ranah analisis dan visualisasi

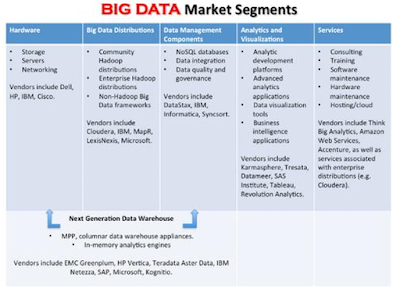

seperti Karmasphere. Jeff Kelly membuat presentasi segmentasi Bigdata market yang cukup menarik,

Segmentasi diatas menunjukan peluang besar bagi ragam

startup untuk masuk kedalam market Bigdata.

IDC memprediksi bahwa market Bigdata akan mencapai $16.1

billion pada tahun 2014, tumbuh 6 kali lebih cepat dibandingkan rata-rata

market IT. Jumlah ini termasuk infrastruktur (server, storage, dll), servis,

dan software. Saya belum melakukan eksplorasi lebih lanjut mengenai market

Bigdata di Indonesia, namun jika melihat kebutuhan Bigdata di US maka tidak

salah apabila muncul istilah “Bigdata is the new H1B Visa”. Tidak percaya? Coba

lihat pencarian job ini (Hadoop Developer) dan ini (Hadoop System Administrator) di

Linkedin, itu baru sebagian kecil saja dan baru seputaran hadoop developer

serta system administrator namun sudah menunjukan betapa besarnya market

Bigdata di US.

2.8 Pemanfaatan Big Data

2.8.1 Pemanfaatan Big Data dalam Bidang Agrikultur

Sebagai negara agraris

dengan lebih dari 30 juta petani dan lahan pertanian yang luas, Indonesia

tentunya akan diuntungkan dengan adaptasi teknologi Big Data khususnya di

bidang agrikultur. Regi Wahyu CEO dari Mediatrac, perusahaan analisa Big Data

terkemuka di tanah air, dalam presentasinya bercerita tentang bagaimana Big

Data bisa membantu para petani. Ide ini muncul di saat Regi merasa tertantang

untuk meningkatkan taraf hidup petani. Lalu bagaimana caranya?

Regi merekrut sejumlah mahasiswa berbakat

dari Universitas Padjadjaran untuk melakukan riset di sebuah areal persawahan

di Jawa Barat. Tahap pertama yang dilakukan adalah menganalisa kualitas tanah

dan luas sawah dengan foto aerial. Tim riset mengambil 400 foto untuk

tiap 1 hektar sawah. Tahap selanjutnya adalah mengamati pertumbuhan tinggi padi

setiap minggu dan juga mengumpulkan data cuaca dari hari ke hari.

Informasi-informasi yang telah dikumpulkan

tersebut akhirnya menjadi Big Data yang bisa digunakan untuk membantu para

petani meningkatkan produksi panen, memprediksi waktu yang tepat untuk bercocok

tanam, dan lainnya. Kedepannya, proyek ini akan dilakukan juga di daerah lain.

2.8.2 Pemanfaatan Big Data untuk Mengurangi

Kecurangan Pajak

Kepala Direktorat Jenderal

Pajak, Iwan Djuniardi, juga ikut serta dalam konferensi Big Data ini. Iwan

membawakan topik pemanfaatan Big Data untuk meningkatkan pendapatan pajak

negara. Menurut Iwan, hingga saat ini kesadaran masyarakat untuk membayar pajak

masih rendah sehingga setiap tahun Dirjen Pajak tidak pernah memenuhi target

pendapatan pajak.

Penerapan teknologi Big Data dalam perpajakan

ini masih dalam tahap pengembangan. Iwan sempat menampilkan demo dari sistem

pajak online dalam konferensi Big Data kemarin. Demo tersebut memperlihatkan

visualisasi yang sangat detail seperti silsilah keluarga, jenis dan barang

kekayaan apa saja yang dimiliki, serta jenis pajak dan status apakah sudah

membayar pajak atau belum.

Dengan teknologi ini, tentunya pemerintah

bisa meningkatkan kesadaran membayar pajak, mengurangi penipuan pajak, dan

mengoptimasi pendapatan negara.

2.8.3

Pemanfaatan Teknologi Wearable dalam

Big Data

Teknologi wearable biasanya

digunakan untuk membantu aktivitas sehari-hari seperti komunikasi dan navigasi.

Tapi di tangan Daniel Oscar Baskoro, teknologi wearable telah

menjelma sebagai teknologi pengumpul informasi Big Data.

Oscar merupakan mahasiswa dan peneliti di

Universitas Gajah Mada. Ia telah berhasil memenangkan banyak penghargaan dalam

perjalanan karirnya seperti menjadi Google Ambassador untuk wilayah Asia

Tenggara, pemenang kompetisi World Bank Global Winner Award di London dengan

aplikasi bencana alam, dan masih banyak lagi. Dalam presentasinya, Oscar

menjelaskan tentang teknologi wearable dan menampilkan

sejumlah aplikasi yang ia kembangkan untuk Google Glass dan smartphone, yaitu

Quick Disaster, Weaver, Realive, dan Stress Rate.

Quick Disaster merupakan aplikasi bencana

alam yang akan membantu pengguna saat terjadi dan setelah bencana alam.

Misalnya saat terjadi gempa bumi, Google Glass akan membantu memberikan solusi

di saat bencana itu terjadi dengan memberikan navigasi jalur evakuasi. Setelah

bencana terjadi, pengguna bisa mengambil gambar dan melaporkan

kerusakan-kerusakan yang terjadi akibat bencana alam melalui aplikasi ini.

Weaver adalah aplikasi untuk

meningkatkan pengalaman berkendara yang awalnya ia kembangkan untuk Toyota.

Aplikasi ini bisa melacak berapa banyak bahan bakar minyak yang dihabiskan,

mengetahui rasio penggunaan bahan bakar, dan mengetahui berapa banyak kadar CO2

yang dikeluarkan setiap mobil.

Realive merupakan aplikasi untuk melaporkan

kejadian secara real time seperti apabila ada kebakaran,

kecelakaan, dan kejadian lain. Sedangkan Stress Rate, merupakan aplikasi untuk

mengetahui tingkat kepadatan penduduk di suatu area publik. Kedua aplikasi ini

masih dalam tahap pengembangan dan akan diluncurkan dalam waktu dekat.

2.8.4 Kesempatan dan

Tantangan Big Data untuk Menikatkan Sektor Kesehatan

Topik selanjutnya yang tidak kalah menarik

adalah pemanfaatan Big Data di sektor kesehatan yang disajikan oleh Anis Fuad,

peneliti dari Universitas Gajah Mada. Dalam presentasinya, Anis menjelaskan

situasi sektor kesehatan di Indonesia yang mana saat ini setiap klinik,

puskesmas, dan rumah sakit menggunakan software yang berbeda-beda untuk

mencatat data pasien. Data yang dikirim Dinas Kesehatan pun masih sangat

sederhana dan tidak semuanya lengkap. Selain itu, sumber informasi yang bisa

dikumpulkan sangat banyak mulai dari klinik, data kesehatan pasien, finansial,

admistrasi, hingga media sosial. Dengan

peran teknologi Big Data, semua informasi kesehatan penduduk Indonesia akan

menjadi terpusat. Sehingga data tersebut bisa diolah dan dianalisa untuk

meningkatkan sektor kesehatan di Indonesia seperti melakukan prediksi penyakit

dan mengetahui tingkat kesehatan penduduk di tanah air.

BAB

III

SIMPULAN

3.1 Simpulan

Big Data adalah kemampuan utuk

mengelola data dengan volume besar yang berbeda dengan kecepetan yang tepat dan

dalam kerangka waktu yang tepat memungkinkan penggunanya untuk dapat memperoleh

nilai daripada tiap informasi yang terkandung dalam Big Data. Big data juga

dapat didefinisikan sebagai data yang berkuran raksasas yang mana volumenya

terus bertambah, terdiri dari varietas data, terbentuk secara terus menerus

dengan kecepatan tertentu dan harus diproses dengan kecepatan tertentu.

Sebuah informasi atau data dapat

disebut Big Data apanila memiliki 1 dari tiga karakteristik yang terdiri dari

Volume, Variety dan Velocity. Banyak

sekali pengguna big data baik itu individu maupun organiasional (perusahaaa,

Bisnis, Pemerintah, Pasara dan lainnya) yang memiliki kumpulan dari banyak data

yang terus menerus menumpuk. Karena terlalu banyaknya data tersebut terkadang

tidak dapat mengetahui tindakan apa yang harus diambil terhadap kumpulan data

tersebut agar nantinya data tersebut berguna dan mempunyai nilai bagi pihak

yang berkepentingan. Perlu adanya analisis terhadap data tersebut beberapa

vendor di pasar saaat ini sudah banyak yang menawarkan solusi terkait dengan

pengambilan nilai terhadap Big Data. Sepertinya misalnya IBM dengan

mengintegrasikan seluruh platform termasuk embedding analisi. Produknya

termasuk warehouse infoSphere yang memiliki built data mining sendiri.

Penggunaan Big Data yang telah di

proses secara analisis sehingga menciptakan nilai informasi yang berguna bagi

penggunanya akan dapat memecahkan masalah dan menemukan solusi solusi. Perlu

diingat bahwa Big Data bukan hanya sekedar ukuran, namun juga terdapat

keragaman di dalamnya. Hal ini lah yang membedakan Big Data dengan system

manajemen data lainnya.

3.2 Kritik

Big Data yang merupakan gabungan dari

berbagai jenis data baik secara volume, variatas, dan velocity. Perusahaan

perusahaan yang memang tidak bergerak di bidang IT atau tidak bersinggungan

langsung ke bidang ini harus menggunakan jasa dari pihak ketiga. Penggunaan

jasa pihak ketiga mengingat bahwa pengelolaan data yang besar agar dapat

tercipta infomrasi data yang valuable bagi perusahaan adalah hal yang rumit.

Penggunaan infrastruktur yang cukup banyak dan sumber daya manusia yang ahli

adalah mahal apabila dimiliki perusahaan yang bukan bergerak di bidang IT.

Pengelolaan oleh ihak ketiga ini juga harus

memperhatikan bahwa pengeloaan Big Data harus benar benar bisa memberikan

solusi atas maslaah organisasi. Perlu adanya Big Data yang bisa dikelola secara

murah oleh perusahan yang tidak terlalu besar atau Small Medium Enterprise agar

nantinya informasi tidak hanya dikuasi oleh perusahaan perusahaan besar.

3.3 Saran

Perusahaan yang menggunakan data

yang sangat banyak dan terus memperbaharui informasinya setiap waktu disarankan

untuk menerapkan Big Data dan bukan hanya sekedar system manajamen data yang

biasa saja seperti data base. Kumpulan data tersebut harus diolah dan

dianalisis menjadi sebuah data dan informasi yang berguna pemecahan masalah.

Seperti misalnya Big Data yang dilakukan oleh Google dalam mesin pencarinya.

Begitupula Amazon dan eBay yang menganalisa kebiasaan belanja dari konsumennya.

Kecepatan dan ketepatan dalan penggunaan informasi Big Data sangat krusial bagi

perusahaan.

Beberapa solusi yang biasanya ditawarkan dengan

menggunakan Big Data adalah:

1.

Social data analysis.

Solusi ini sepertinya idola buat startup dikarenakan akses data dari social

media, seperti facebook dan twitter, yang relatif mudah didapat. Dengan social

data analysis bisa dikembangkan kemungkinan lain seperti untuk sentiment

analysis, customer segementation, mengukur efektifitas marketing, dan

lain-lain.

2.

Historical data analysis.

Solusi ini menganalisis data masa lalu yang dimiliki suatu perusahaan. Misalnya

data penjualan. Solusi ini berfungsi untuk mencari trend atau kecenderungan

data sehingga bisa memberikan gambaran apa yang terjadi dimasa lalu.

3.

Predicitive analysis.

Solusi ini pada umumnya digabungkan dengan solusi historical data analysis.

Dari data masa lalu maka dikembangkan kecerdasarn buatan yang bisa memprediksi

kejadian dan trend di masa yang akan datang. dengan demikian tindakan

antisipasi bisa dilakukan mulai dari sekarang.

Daftar

Pustaka

https://openbigdata.wordpress.com/2014/09/

Komentar

Posting Komentar